数据科学家的道德责任是什么?

“我们所谈论的是一场灾难性的变革……我们所谈论的是一个拥有复杂技术和能力的强大外国势力,他们能够干预总统选举,并在全国各地制造冲突和不满……你们承担着这份责任。你们创造了这些平台。现在它们正在被滥用,”范斯坦参议员(Senator Feinstein)在本周的参议院听证会上表示。谁制造了这场灾难性的变革?谁承担着这份巨大的责任?她当时正在与科技公司的高管对话,并指责的是数据科学家们的工作。

数据科学会对我们的世界产生毁灭性影响,例如在2016年大选前,煽动性的俄罗斯宣传内容在Facebook上展示给了1.26亿美国人(这也是上文所述参议院听证会的主题),或者通过Facebook传播的谎言正在助长缅甸的种族清洗。超过50万罗兴亚人因系统的谋杀、强奸和焚烧而被赶出家园。数据科学是Facebook新闻推送的基础,它决定了哪些内容被优先展示以及由谁看到。

作为数据科学家,我们坐在电脑屏幕后编写代码时,可能很少会去思考那些生活可能因我们的算法而改变的人们。然而,我们对我们的世界以及那些将受到我们工作影响的人们负有道德责任。技术本质上是关于人类的,在创造技术时忽视人类心理学、社会学和历史是危险的。即使抛开我们的道德责任不谈,你写的代码也可能让你入狱服刑,就像那位帮助开发作弊软件以通过联邦排放测试的大众汽车工程师被判处3.5年监禁一样。这是他的雇主要求他做的,但听从老板的命令并不能让你免责,这也不是能在法庭上保护你的借口。

作为一名数据科学家,你可能在产品决策中没有太多发言权,但你可以提问和提出问题。尽管坚持做正确的事情可能令人不适,但你很幸运,因为你属于全球人口中仅有0.3-0.5%会编程的人。这种知识带来了将其用于正途的责任。有很多原因可能让你觉得工作受困(需要签证、养家糊口、行业新手);然而,我发现身处不道德或有毒工作环境中的人们(包括我过去的自己)总是低估了自己的选择。如果你发现自己处于不道德的环境中,请至少尝试申请其他工作。数据科学家的需求很高,如果你目前正从事数据科学家工作,很可能还有其他公司愿意雇用你。

意料之外的后果

我们都应该做的一件事是思考恶意行为者如何可能滥用我们的技术。以下是一些需要考虑的关键领域:

- 喷子(Trolls)如何利用你的服务骚扰弱势群体?

- 威权政府如何利用你的工作进行监控?(这里有一些可怕的监控工具)

- 你的工作如何可能被用于传播有害的虚假信息或宣传?

- 可以采取哪些保障措施来减轻上述问题?

数据科学影响世界

算法的后果不仅危险,甚至可能是致命的。Facebook目前正被用来传播关于缅甸少数民族罗兴亚人的非人化虚假信息。如上文所述,超过50万罗兴亚人因系统的谋杀、强奸和焚烧而被赶出家园。对于缅甸的许多人来说,Facebook是他们唯一的新闻来源。正如《纽约时报》引述的那样,一个有着许多限制穆斯林(罗兴亚人是穆斯林,而该国大多数人是佛教徒)规定的村庄的当地官员承认他从未见过穆斯林,但他说,“[他们]这里不欢迎,因为他们很暴力,他们有这么多妻子和孩子,疯狂地繁殖。”我必须感谢Facebook,因为它给了我缅甸的真实信息。

Superconductive Health 的首席执行官 Abe Gong 讨论了一个在美国法庭上使用的刑事再犯算法,该算法包含了关于一个人的父母是否分居以及其父亲是否曾被捕的数据。需要明确的是,这意味着人们的刑期长短取决于他们父母所做的事情。即使这提高了模型的准确性,包含这些信息也是不道德的,因为它完全超出被告的控制范围。这是一个例子,说明为什么数据科学家不应该只是不假思索地优化一个简单的指标,我们还必须思考我们希望生活在什么样的社会中。

失控的反馈循环

Meetup 的首席机器学习工程师 Evan Estola 讨论了一个例子,即男性对技术聚会(meetup)表达了比女性更多的兴趣。Meetup 的算法可能会向女性推荐更少的技术聚会,结果是更少的女性会了解到并参加技术聚会,这可能会导致算法向女性推荐的技术聚会进一步减少,如此循环形成一个自我强化的反馈循环。Evan 和他的团队做出了道德决定,让他们的推荐算法不产生这样的反馈循环。看到一家公司不仅仅是不假思索地优化某个指标,而是考虑其影响,这是令人鼓舞的。

虽然 Meetup 选择避免了这样的结果,但 Facebook 提供了一个例子,说明其允许失控的反馈循环肆意蔓延。Facebook 通过向用户介绍更多阴谋论来使其激进化。正如关于虚假信息传播的研究员 Renee DiResta 所写,一旦人们加入一个具有阴谋论倾向的 [Facebook] 群组,他们就会被算法推荐到无数其他类似群组。加入一个反疫苗群组,你的推荐中就会出现反转基因、化学凝结尾踪迹、地球是平的(是的,真的如此)以及“自然疗法治愈癌症”等群组。推荐引擎不是将用户拉出“兔子洞”,而是将他们推得更深。

另一个例子是预测性警务算法,它预测某些社区的犯罪率更高,导致更多的警察被派往这些社区,这可能会导致这些社区记录的犯罪率更高,以此类推。计算机科学关于预测性警务中的失控反馈循环的研究阐述了这种现象如何产生以及如何预防。

迷思:“这是一个中立平台”,“用户如何使用我的技术不是我的错”,“算法是公正的”

作为一名科技行业之外,但经常接触全新技术的人,《硅谷》节目的演员 Kumail Nanjiani 提供了一个有益的视角。他最近在推特上表示,他和剧组其他成员经常看到一些让他们因潜在的滥用风险而感到恐惧的技术。Nanjiani 写道,“我们会向他们提出我们的担忧。我们意识到,技术伦理影响似乎完全没有被考虑。他们甚至没有一个现成的、排练好的答案。他们对被问到这个问题感到震惊。这意味着没有人问这些问题。“我们制造它不是为了那个目的,但人们选择使用它的方式不是我们的错。会建立起安全保障。”但技术发展太快了。人类或法律根本无法跟上……只有“我们能做到吗?”,从不问“我们应该做到吗?”

对要求加强伦理或问责的呼吁,科技界人士(如马克·扎克伯格)常见的辩护是说他们正在构建中立平台。这种辩护站不住脚,因为任何技术都需要做出许多决策。以 Facebook 为例,决策包括新闻推送中优先显示什么、优化哪些指标(例如广告收入)、向广告商和用户提供哪些工具和过滤器,以及解雇人工编辑等,这些都影响了产品(以及许多国家的政治局势)。社会学教授 Zeynep Tufecki 在《纽约时报》上撰文指出,Facebook 向定位到“仇恨犹太人者”的广告并非偶然的失误,而是该平台结构造成的意料之中的结果。

另一些人声称他们不能采取行动遏制网络骚扰或仇恨言论,因为这会与言论自由原则相悖。Fog Creek 软件公司 CEO Anil Dash 写道,“网络滥用的最终效果是压制 [代表不足的] 社区成员。允许滥用损害了言论自由。允许滥用者主导对话的社区不仅压制边缘化人群,还会赶走任何对这种敌对环境感到反感的理性或有思想的人。” 所有科技公司都在决定将谁纳入其社区,无论通过行动还是隐含的无行动。Valerie Aurora 在一篇关于宽容悖论的帖子中驳斥了类似的论点,解释了当某些群体被压制和恐吓时,言论自由如何可能整体上减少。选择不对滥用和骚扰采取行动仍然是一个决定,而且这个决定将对谁使用你的平台产生巨大影响。

一些数据科学家可能认为自己是公正地分析数据。然而,正如 iRobot 数据科学总监 Angela Bassett 所说,“不是数据可能有偏见。数据本身就是有偏见的。” 了解你的数据是如何生成的,以及它可能包含哪些偏见。我们正在我们创建的算法中编码甚至放大社会偏见。在最近接受《连线》杂志采访时,AI Now Institute 的联合创始人、微软首席研究员 Kate Crawford 解释说,数据不是中立的,数据也不能被中立化,“数据将永远带有其历史的痕迹。”我们需要理解这段历史以及它对我们构建的系统意味着什么。

偏见

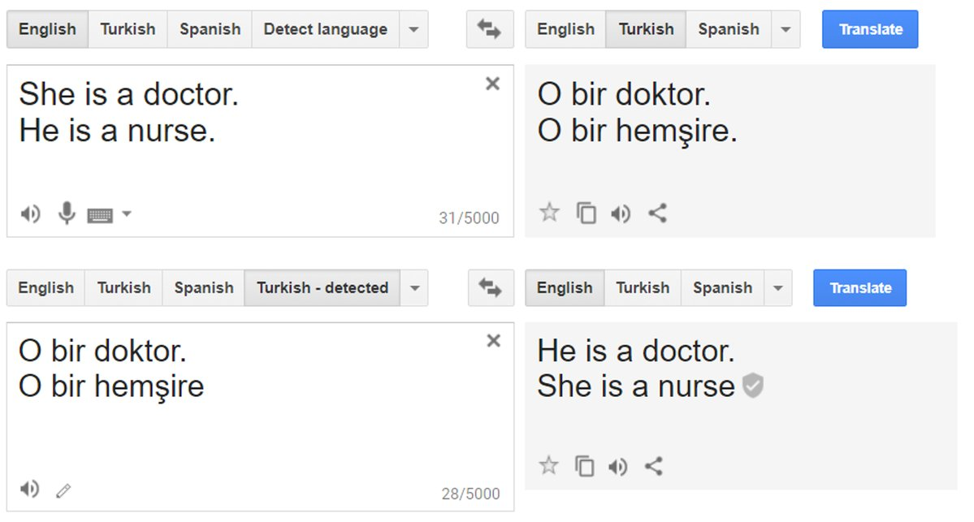

尽管我厌倦了撰写和讲述关于偏见的话题,但我仍将继续,因为似乎许多人还没有明白这个道理。我沮丧地看到有影响力的机器学习教授Pedro Domingos 最近发推说机器学习算法不会歧视,现在更令我震惊的是,这条推文获得了30次转发和95个赞。数据科学中偏见的例子不胜枚举,包括: * Google Photos 自动将黑人标记为“大猩猩” * 评估刑事再犯风险的软件,错误地预测黑人被告是高风险的可能性是其他人的两倍 * Google 流行的 Word2Vec 语言库创建性别歧视类比,例如 男人→计算机程序员 :: 女人→家庭主妇 * 神经网络学习到“性感”是拥有浅色皮肤 * 一个应用程序,比较求职者的词汇选择、语气和面部动作与现有员工,普林斯顿大学教授 Arvind Narayanan 将其描述为其唯一可想象的目的就是延续社会偏见 * Google Translate 将中性句子转换为“他是一名医生。她是一名护士”

这些有偏见的结果由多种原因造成,包括有偏见的数据集以及产品构建团队缺乏多样性。使用留置测试集并避免过拟合不仅是良好的实践,也是一项伦理要求。过拟合通常意味着在训练集中未得到充分代表的数据类型上(字面上就是代表不足或少数派数据)错误率更高。

您在招聘中的责任

除非我们拥有更具多样性的团队来构建技术,否则我们将继续看到上述错误。如果您参与面试候选人或影响招聘决策,您有责任努力使招聘流程减少偏见。请注意,认为自己“性别盲”或“肤色盲”是行不通的,而认为自己客观反而会让你更加有偏见。公司必须开始做的不仅仅是口头上空谈多样性。

我对如何在公司留住女性以及面试中的偏见进行了广泛研究,包括解决这些问题的实用技巧。Stripe 的工程师 Julia Evans 认为她可以更好地进行电话面试,因此她为自己创建了一个评估候选人的标准,这个标准最终被采纳为公司范围内的规范。她写了一篇关于做出微小的文化改变的优秀文章,无论您担任什么职位,都应该有所帮助。

系统性与监管回应

这篇博文是以个体数据科学家为目标受众而写的,但系统性和监管性的回应同样必要。Renee DiResta 将金融市场中高频交易的出现与社交网络上机器人和虚假信息宣传活动的兴起进行了类比。她认为,就像需要对金融市场进行监管以应对日益增加的脆弱性和恶意行为者一样,社交网络也需要监管来应对日益增加的脆弱性和恶意行为者。Kate Crawford 指出,提议的伦理准则与实际发生的情况之间存在巨大差距,因为我们没有建立问责机制。

更多资源

数据科学伦理的话题过于庞大和复杂,无法在一篇博文中全面涵盖。我鼓励您就此话题进行更多阅读,并与您的同事和同行讨论。以下是一些可供进一步学习的资源:

- 俄勒冈健康与科学大学 CS & EE 伦理学 课程阅读材料列表

- 康奈尔大学 数据科学伦理与政策 课程阅读材料列表

- 科罗拉多大学博尔德分校 信息伦理与政策 课程阅读材料列表

- 纽约大学的 AI Now Institute,研究人工智能的社会影响。查看他们的 AI Now 2017 报告

- 机器学习中的公平性、问责制和透明度组织,包括他们的相关学术论文列表

- 数据与社会(Data & Society)研究所的阅读材料

- 社会媒体集体(Social Media Collective)的批判性算法研究:阅读列表

- 关于计算研究数据伦理的 PERVADE 项目精选出版物

- Data Science Renee 整理的机器学习中偏见文章汇编

- Anil Dash 的关于网络滥用的不朽迷思

- 我的工作坊:词嵌入、机器学习中的偏见、为什么你不喜欢数学以及为什么人工智能需要你

- 我在 QCon.ai 的主旨演讲:分析与预防机器学习中的无意识偏见

- 我的另一篇文章,关于 Facebook 对其在缅甸种族灭绝中所扮演角色的平淡回应(特别是与它对德国潜在经济处罚的回应相比),什么具体的监管措施能够帮助我们,Facebook 说客持续推动削弱我们仅有的隐私法律,以及 Free Basics(又称 Internet.org)在全球仇恨言论和暴力中所扮演的角色。

您的责任

你可以使用数据科学做一些很棒且有意义的事情(例如诊断癌症、阻止森林砍伐、提高农业产量以及帮助帕金森病患者),你也可以(通常是无意的)利用数据科学促成可怕的事情,正如本文中的例子所示。成为一名数据科学家既意味着巨大的机遇,也意味着巨大的责任,要运用我们的技能而不是让世界变得更糟。归根结底,数据科学是关于人类的,不仅仅是产品的用户,而是所有将受到我们工作影响的人。