人工智能正被越来越多地用于做出重要决策。许多人工智能专家(包括谷歌人工智能负责人Jeff Dean和Coursera及deeplearning.ai创始人吴恩达)表示,关于有意识机器人的警告被夸大了,但其他危害却没有得到足够的关注。我同意这一点。我是一名人工智能研究员,我担心我们已经看到的一些社会影响。特别是,以下5件事让我对人工智能感到害怕:

最后,我将简要分享一些我们可以尝试解决这些问题的积极方法。

在我们深入探讨之前,我需要澄清一个重要的点:算法(以及它们所属的复杂系统)可能出错。这些错误来源多样:代码中的错误、不准确或有偏见的数据、我们必须进行的近似(例如,你想衡量健康状况却使用医院再入院率作为代理指标,或者你对犯罪感兴趣却使用逮捕率作为代理指标。这些事物相关,但并非完全一致)、不同利益相关者(政策制定者、数据收集者、算法编码者、部署者)之间的误解、计算机系统与人类系统如何互动等等。

本文讨论了各种算法系统。我个人对定义之争不太感兴趣,比如什么才算“人工智能”,或者某个特定算法是否算“智能”。请注意,本文描述的动态对于简单算法和复杂算法都适用。

- 算法经常被实施,但没有解决错误的途径。

阿肯色州在实施用于确定人们医疗福利的软件后,许多人的护理量急剧减少,但他们没有得到任何解释,也没有任何申诉途径。Tammy Dobbs是一位患有脑瘫的女性,她需要帮助才能起床、上厕所、获取食物等等,她的帮助时长突然每周减少了20小时,使她的生活变得更糟。最终,经过漫长的法庭诉讼,软件实施中的错误被揭露,Tammy的帮助时长得到了恢复(以及许多受错误影响的其他人的时长)。

对五年级教师Sarah Wysocki课堂的观察得到了积极评价。她的副校长写道:“很高兴能来到一个有效结合了扎实教学、积极学生和积极学习环境的课堂。” 两个月后,她与另外200多名教师一起被一个不透明的算法解雇了。家委会主席和Wyscoki学生的一位家长形容她是“我接触过的最好的老师之一。每次我见到她,她都对孩子们很关心,检查他们的功课,她花时间陪伴他们并确保一切妥当。” 人们在没有解释的情况下失去所需的医疗保健,或者在没有解释的情况下被解雇,这真是反乌托邦式的景象!

正如我在之前的一篇文章中所述,人们使用算法输出的方式与使用人类决策的方式不同: - 算法更有可能在没有申诉流程的情况下实施。 - 算法通常被大规模使用。 - 算法系统成本低廉。 - 人们更倾向于认为算法是客观或没有错误的。正如Peter Haas所说,“在人工智能中,我们拥有米尔格拉姆的最终权威人物”,他指的是Stanley Milgram著名的实验,该实验表明大多数人会服从权威人物的命令,甚至达到伤害或杀害他人的程度。人们相信被视为客观和正确的算法的可能性会高多少呢?

这些因素之间存在很多重叠。如果实施算法的主要动机是降低成本,那么增加申诉流程(甚至勤奋检查错误)可能会被视为“不必要的”开支。Cathy O’Neill,这位在哈佛大学获得数学博士学位的人,写了一本名为《数学毁灭性武器》的书,她在书中阐述了算法如何不成比例地影响穷人,而特权阶层更有可能仍然获得人类的关注(在招聘、教育等方面)。

- 人工智能让人更容易逃避责任。

让我们回到阿肯色州用于确定医疗福利的错误软件案例。这本该如何避免?为了防止重度残疾人士错误地失去所需的医疗保健,我们需要谈论责任。不幸的是,复杂系统往往导致一种动态,即没有人对结果感到负责。

医保福利算法的创建者Brant Fries(该算法已在美国50个州的一半以上投入使用,他一直在从中赚取版税)将责任归咎于州政策制定者。我敢肯定州政策制定者可以将责任归咎于软件实施者。当被问及是否应该有办法向失去医疗保健的残疾人士解释算法如何工作时,Fries冷漠地说:“这也许是我们应该做的事。是啊,我也许还应该清理一下床底的灰尘。”然后后来澄清说,他认为那是别人的责任。

这种推卸责任和不承担责任的现象在许多官僚机构中很常见。正如danah boyd观察到的,“官僚主义常被用来转移或逃避责任。在一个复杂的系统中,你将责任归咎于谁?” Boyd以纳粹德国的高级官员为例,他们不认为自己应对大屠杀负责。boyd继续说道,“今天的算法系统正在扩展官僚主义。”

另一个没有人感到负责的例子来自对黑帮犯罪进行分类的研究案例。洛杉矶警察局(以及加州其他3个执法机构)建立的一个黑帮成员数据库被发现包含42名在被添加到黑帮数据库时未满1岁的婴儿(据说其中28人承认是黑帮成员)。请记住,这只是最明显的一些错误——我们不知道还有多少其他人被错误地纳入其中。

我提出这一点并非主要是为了指责或归咎。然而,在一个没有人对结果(可能包括重度残疾人士失去所需的医疗保健,或无辜者被贴上黑帮成员标签)感到负责的复杂系统世界里,情况令人不快。我们的工作几乎总是大局中的一小部分,但责任感对于尝试解决和预防负面结果是必要的。

- 人工智能编码并放大了偏见。

但是,算法偏见不正是世界的真实反映吗?每次我谈论偏见时,都会被问到这个问题的变体。对此我的回答是:不,我们的算法和产品正在影响世界,并且是反馈循环的一部分。考虑一个预测犯罪并决定向何处派遣警力的算法:向某个特定社区派遣更多警力不只是结果,也是原因。更多的警力可能导致在特定社区发生更多逮捕,这可能会导致算法向该社区派遣更多警力(这种机制在关于失控反馈循环的这篇论文中有所描述)。

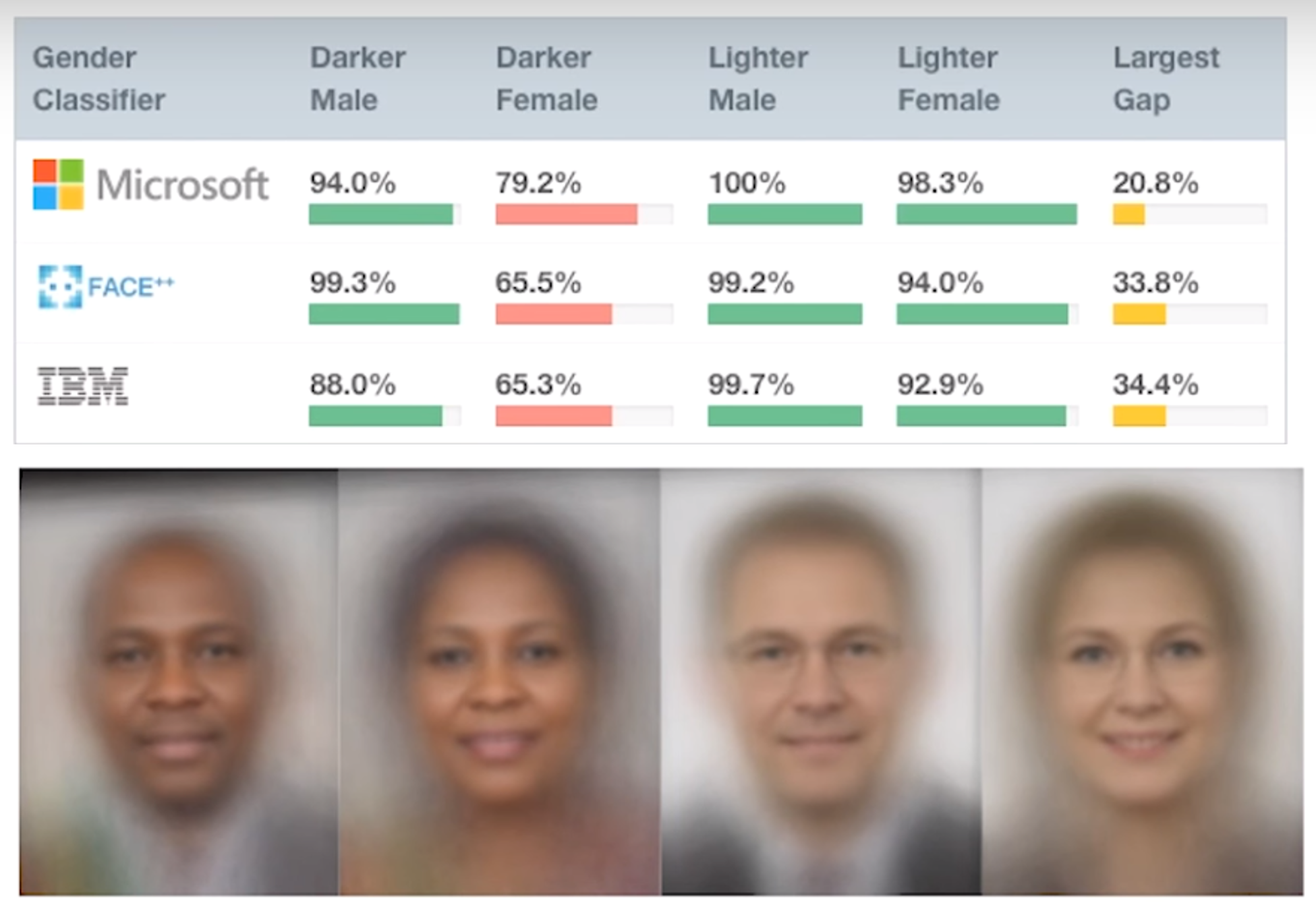

偏见正在各种应用中被编码甚至放大: - 用于判决刑期的软件对黑人被告的误报率是白人被告的两倍 - 来自亚马逊、微软和IBM的计算机视觉软件在有色人种上的表现明显更差

- 词嵌入是Gmail智能回复和谷歌翻译等语言工具的构建模块,它可以生成有用的类比,例如罗马:意大利 :: 马德里:西班牙,以及有偏见的类比,例如男人:计算机程序员 :: 女人:家庭主妇。

- 亚马逊开发的招聘软件中使用的机器学习会惩罚那些就读于女校的申请人,以及简历中包含“women’s”(女性的)这个词的申请人。

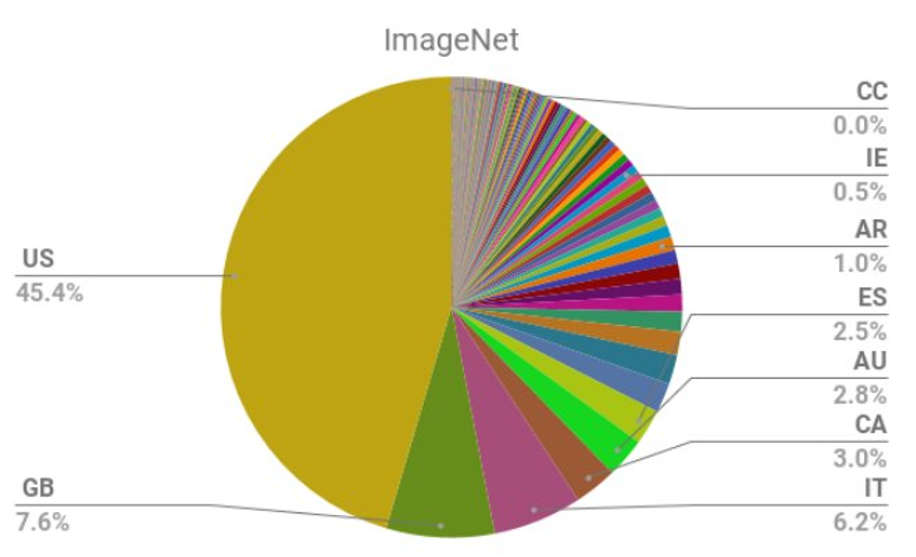

- ImageNet是世界上研究最广泛的图像数据集,其中超过三分之二的图像来自西方世界(美国、英国、西班牙、意大利、澳大利亚)。

由于机器学习产品正经历寒武纪大爆发,现在和未来几年固化的偏见可能在未来很长一段时间内产生不成比例的巨大影响(几十年后将更难消除)。

- 将指标优化置于一切之上会导致负面结果。

全球每天人们观看10亿小时的YouTube(没错,是“每天”)。YouTube的成功很大程度上归功于其推荐系统,其中算法选择的视频在前一个视频结束后会自动播放。不幸的是,这些推荐不成比例地倾向于宣传白人至上主义、否认气候变化以及否认困扰美国的群体枪击事件的阴谋论。这是怎么回事?YouTube的算法试图最大化人们在YouTube上花费的时间,而阴谋论者观看YouTube的时间显著多于信任各种媒体来源的人。不幸的是,一个仅仅试图最大化用户在其自身平台花费时间的推荐系统,将会激励那些告诉你“其他媒体都在撒谎”的内容。

“YouTube可能是21世纪最具煽动性的工具之一,”Zeynep Tufekci教授在《纽约时报》上写道。Guillaume Chaslot是一位前YouTube工程师,现已成为揭秘者。他一直直言不讳地指出YouTube造成的危害,并与《卫报》和《华尔街日报》合作研究YouTube推荐内容中的极端主义和偏见。

YouTube隶属于谷歌,后者通过积极向易受影响的人们推荐阴谋论来赚取数十亿美元,而社会其他部分则承担着威权政府崛起、白人至上主义运动复苏、未能应对气候变化(即使极端天气正在产生越来越多的难民)、对主流新闻来源信任度下降以及未能通过合理枪支法律等外部化成本。

这个问题是“指标的暴政”的一个例子:指标只是你真正关心的事物的代理,不假思索地优化一个指标可能导致意想不到的负面结果。一个类似的例子是,当英国开始公布外科医生的成功率时,心脏外科医生开始拒绝进行风险高(但必要)的手术,以尽量保持他们的评分尽可能高。

回到那位被算法解雇的受欢迎的五年级教师的故事,她怀疑被解雇的根本原因是她的入学学生前一年的考试成绩异常高(导致在她教学后他们的成绩看起来下降到更平均的水平),以及他们以前的老师可能作弊了。随着美国教育政策开始过度强调学生考试成绩作为评估教师的主要方式,格鲁吉亚、印第安纳州、马萨诸塞州、内华达州、弗吉尼亚州、德克萨斯州以及其他地方发生了教师和校长通过修改学生成绩来作弊的普遍丑闻。当指标被给予过度重视时,试图操纵这些指标的行为就会变得常见。

- 大型科技公司缺乏问责制。

主要科技公司是推动人工智能发展的主力,它们的算法影响着数十亿人。不幸的是,这些公司没有任何问责制。YouTube(谷歌旗下)正在助长人们走向白人至上主义的极端化。谷歌允许广告商针对搜索“黑人毁了社区”等种族歧视短语的人群,而Facebook允许广告商针对“仇恨犹太人者”等群体。亚马逊的面部识别技术错误地将28名国会议员识别为罪犯,但它已经被警察部门使用。Palantir的预测性警务技术在新奥尔良使用了6年,市议会成员甚至不知道该计划的存在,更谈不上任何监督。所有主要平台的新闻源/时间线/推荐算法都倾向于奖励煽动性内容,并优先向用户展示。

2018年初,联合国裁定Facebook在缅甸持续的种族灭绝事件中发挥了“决定性作用”。联合国调查员表示:“我担心Facebook现在已经变成了一个怪兽。” 对于一直关注缅甸局势的人来说,这个结果并不意外。早在2013年,就有人警告过Facebook的高管,平台正在被用于传播非人化的仇恨言论和煽动针对少数民族的暴力,2014年和2015年也再次发出了警告。早在2014年,半岛电视台等新闻机构就报道了Facebook在煽动缅甸族裔暴力中的作用。

一位知情人士表示,“这不是事后诸葛亮。问题的规模是巨大的,而且已经显而易见。” 2015年,Facebook高管就收到警告,Facebook可能在缅甸扮演与1994年卢旺达种族灭绝期间广播电台所扮演的相同角色。截至2015年,Facebook仅雇用了4名会说缅甸语(缅甸的主要语言)的合同工。

对比Facebook在缅甸的无动于衷,看看他们在德国通过新法律后迅速采取的行动,新法律可能导致最高5000万欧元的罚款。Facebook在不到一年内雇用了1200名德国合同工。2018年,在Facebook首次收到关于其平台被用于煽动缅甸暴力行为的警告五年后,他们雇用了“数十名”缅甸合同工,这仅仅是他们在德国反应的一小部分。可信的大额经济处罚威胁可能是Facebook唯一会回应的事情。

虽然很容易关注那些误导或无效的法规,但我们常常认为那些在很大程度上行之有效的安全标准和法规是理所当然的。一个主要的成功案例来自汽车安全。早期的汽车仪表盘上有尖锐的金属旋钮,在撞车时会刺入人的头骨;平板玻璃窗危险地碎裂;不可折叠的转向柱经常刺穿司机。除此之外,当时普遍认为汽车唯一的问题在于驾驶员,汽车制造商也不希望收集汽车安全数据。消费者安全倡导者花费了几十年才推动讨论如何设计更安全的汽车,并通过了关于安全带、驾驶执照、碰撞测试以及汽车碰撞数据收集的法律。关于这个话题的更多内容,Datasheets for Datasets介绍了电子、制药和汽车行业如何实现标准化的案例研究,而99% Invisible深入探讨了汽车安全的历史(与枪支行业进行了比较和对比)。

我们如何做得更好

好消息是:这里列出的问题都不是算法固有的!我们有办法做得更好

- 确保有有意义的、人工的申诉流程。提前规划如何发现和解决错误。

- 承担责任,即使我们的工作只是系统的一部分。

- 警惕偏见。为数据集创建数据表。

- 选择不只是优化指标。

- 推动对科技行业进行周到的监管和制定标准。

我们面临的问题可能令人恐惧且复杂。然而,我们正处于人工智能和算法自动化日益发展的时代,这一切还非常早期。现在是采取行动的好时机:我们可以改变文化,培养更强的责任感,寻求周到的问责制来平衡大型科技公司拥有的巨大权力,并选择创造更人性化的产品和系统。技术只是一个工具,可以用于好事也可以用于坏事。让我们努力将其用于好事,改善许多人的生活,而不是仅仅为少数人创造财富。

相关文章

您可能对这些关于科技与伦理的相关文章感兴趣