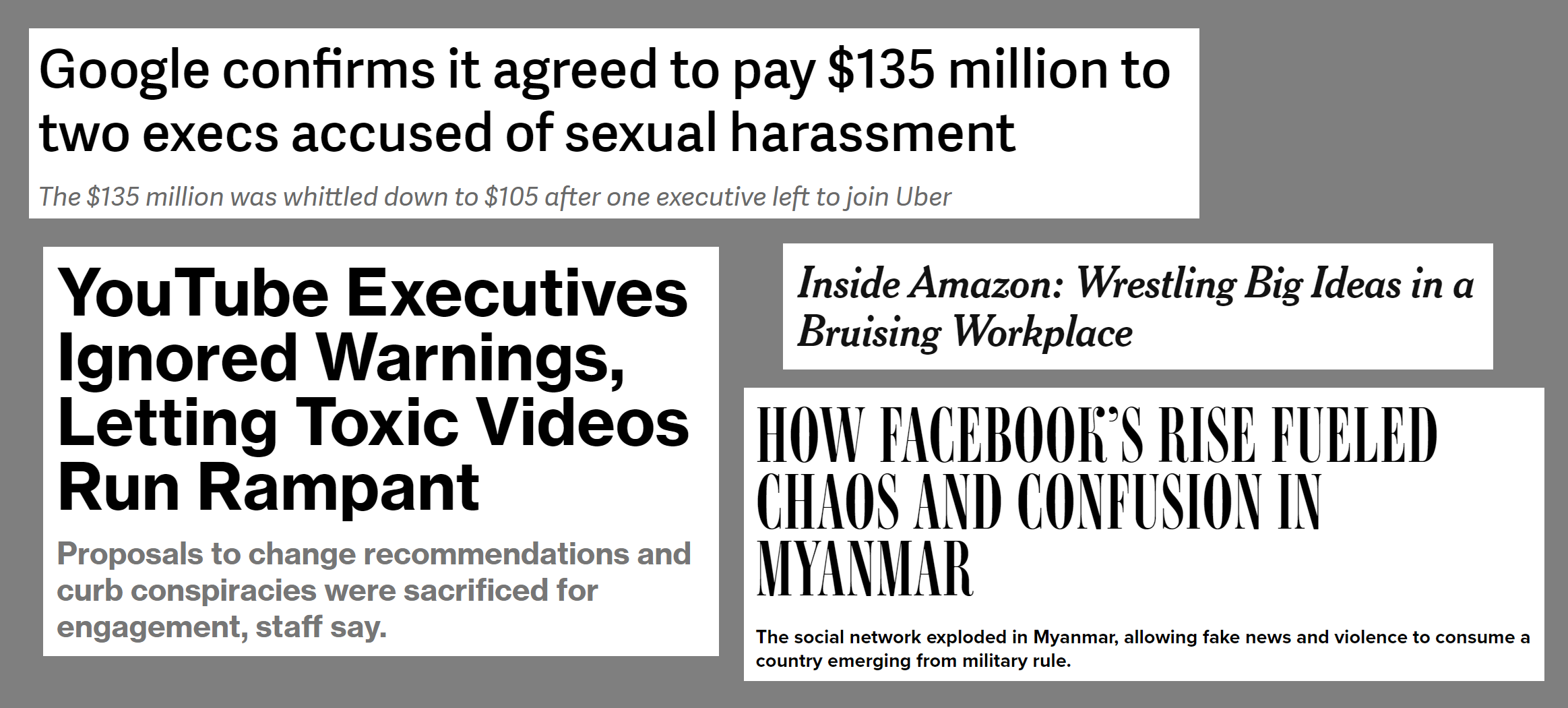

甚至在谷歌宣布成立一个人工智能伦理委员会之前,该委员会成员包括传统基金会的会长,此人反对跨性别者、反对LGBTQ群体和反对移民(该委员会一周后被取消),我们已经知道谷歌领导层在伦理问题上的立场了。这些人同样向被指控性骚扰的高管支付了数千万美元的补偿金(而让受害者一无所有);容忍员工向白人至上主义网站泄露其LGBT+同事的姓名和照片(据一位在谷歌工作11年的知名工程师称);并允许一名高级主管在《纽约时报》上发表误导性声明,涉及一个正在毁掉生命的重大问题。早在亚马逊开始抹黑麻省理工学院的研究人员,这些研究人员指出了亚马逊面部识别技术中的偏见之前,亚马逊总部的多名女性在经历癌症治疗、大型手术或死产后,立刻收到低绩效评估或被列入绩效改进计划(解雇的前兆)。关于Facebook和伦理的话题可以(也确实)单独写一篇文章,但一个关键点是,Facebook的高管在2013年、2014年和2015年就被警告其平台正在被用于煽动缅甸的种族暴力,但直到2018年联合国裁定Facebook在缅甸种族灭绝中已起到“决定性作用”后,他们才采取实质性行动。既然顶级科技公司的领导层似乎不关心“普通”伦理,那么他们当然也无法体现人工智能伦理。

人工智能伦理并非独立于其他伦理,被孤立在一个更性感、更有吸引力的空间里。伦理就是伦理,即使是人工智能伦理,最终也关乎我们如何对待他人以及如何保护人权,尤其是最弱势群体的权利。制造我们当前危机的人不会是解决危机的人,这一切都取决于我们所有人采取行动。 在本系列中,我想分享一些你可以采取的行动,以产生实际的积极影响,并重点介绍一些真实世界的例子。有些行动很大;有些很小;并非所有行动都适用于你的情况,但我希望这能启发你,思考如何以具体的方式做出改变。本系列的每一篇文章都将涵盖5或6个不同的行动步骤。

- 数据项目清单

- 进行伦理风险排查

- 抵制指标的暴政

- 选择广告以外的收入模式

- 让产品和工程团队与信任与安全团队坐在一起

- 在公司内部进行倡导

- 与其他员工组织起来

- 当内部倡导不再有效时离开公司

- 避免非贬低协议

- 支持深思熟虑的法规和立法

- 与记者沟通

- 预先确定你的个人价值观和底线

- 要求你的公司签署SafeFace承诺

- 通过确保弱势群体的员工取得成功来增加多样性

- 通过彻底改革面试和入职流程来增加多样性

- 分享你的成功故事!

数据项目清单

伦理与数据科学(可在线免费获取)一书指出,就像清单帮助医生减少错误一样,它们也能帮助科技从业者减少伦理错误。作者为从事数据项目的人员提出了一个清单。以下是应包含在清单中的内容:

- 我们是否列出了这项技术可能被攻击或滥用的方式?

- 我们是否测试了训练数据,以确保其公平和具有代表性?

- 我们是否研究并理解了数据中可能存在的偏见来源?

- 我们的团队是否反映了意见、背景和思维方式的多样性?

- 我们需要收集或使用数据,需要什么样的用户同意?

- 我们是否有机制来收集用户的同意?

- 我们是否清楚地解释了用户正在同意什么?

- 如果人们因结果而受到伤害,我们是否有补救机制?

- 如果软件在生产环境中行为异常,我们能否将其关闭?

- 我们是否针对不同的用户群体进行了公平性测试?

- 我们是否针对不同的用户群体测试了不同的错误率?

- 我们是否测试和监控模型漂移,以确保我们的软件随着时间推移保持公平?

进行伦理风险排查

即使我们怀有良好意愿,我们的系统也可能被操纵或利用(或以其他方式失效),导致广泛的损害。只需看看Facebook在缅甸种族灭绝中的作用,以及阴谋论通过推荐系统传播如何导致疫苗接种率大幅下降,从而导致可预防疾病死亡率上升(《自然》杂志称病毒式错误信息为“最大的大流行风险”)。

类似于渗透测试在信息安全领域的标准化做法,我们需要主动查找系统潜在的失效、操纵和利用,以防其发生。正如我在前一篇文章中所写,我们需要问:

- 恶意用户如何利用你的服务骚扰弱势群体?

- 专制政府如何利用你的工作进行监控?大规模监控和数据收集甚至多次在人道主义危机或种族灭绝中扮演关键角色)

- 你的工作如何被用于传播有害的错误信息或宣传?

- 可以采取哪些保障措施来减轻上述风险?

马克库拉中心(Markkula Center)的伦理学家开发了一套工程设计与实践伦理工具包。我鼓励你通读全文,但我特别想强调工具1,即伦理风险排查,它将我上述的问题形式化为一个流程,包括定期安排伦理风险排查,并奖励发现新伦理风险的团队成员。

抵制指标的暴政

指标只是你真正关心的事物的代理,而不加思考地优化指标可能导致意想不到的负面结果。例如,YouTube的推荐系统旨在优化观看时长,这导致它积极推广那些声称其他媒体都在撒谎的视频(因为相信阴谋论会促使人们回避其他媒体来源,并最大化他们在YouTube上花费的时间)。这种现象已被记者、学术专家以及前YouTube员工充分记录。

幸运的是,我们不必不加思考地优化指标!《技术上错了》一书的第四章记载了NextDoor如何应对其平台上广泛存在的种族歧视问题,并进行了一系列全面的改革。NextDoor彻底修改了用户报告可疑活动的设计,包括增加了一项新要求,用户必须描述该人除种族外的几个外貌特征才能发布。这些改变导致了用户参与度下降的副作用,但并非所有用户参与都是有益的。

Meetup的首席机器学习工程师Evan Estola讨论了一个例子:男性对科技主题的Meetup表现出比女性更多的兴趣。Meetup的算法可能会向女性推荐更少的科技Meetup,结果女性发现并参加科技Meetup的机会减少,这可能导致算法进一步减少对女性的科技Meetup推荐,从而形成一个自我强化的反馈循环。Evan和他的团队做出了一个伦理决定,他们的推荐算法不创建这样的反馈循环。

选择广告以外的收入模式

个性化广告定位与社会福祉之间存在根本性错位。这体现在多种方式:- 通过将数据增加与利润增加挂钩来激励监控 - 激励煽动性内容,因为这能产生更多点击 - 激励阴谋论,这能让人们在你的平台上停留更久 - 操纵选举 - 房屋广告中的种族歧视 - 招聘广告中的年龄歧视

这些问题可以通过多种方式解决,包括加强政治广告、住房歧视和就业歧视方面的法规和执行;修订第230条,使其仅涵盖内容而非推荐;以及对个性化广告定位征税,就像我们对烟草征税一样(将其视为给社会带来巨大外部成本的事物)。

谷歌/YouTube、Facebook和Twitter等公司主要依赖广告收入,这产生了扭曲的激励。即使人们真心想做正确的事情,持续与错位的激励抗争也是艰难的。这就像你正在节食时,厨房里却堆满了甜甜圈。避免这种情况的一种方法是寻找广告以外的收入模式。开发人们愿意付费购买的产品。许多公司都有其他商业模式,例如Medium、Eventbrite、Patreon、GitHub、Atlassian、Basecamp等等。

个性化广告定位在在线平台中根深蒂固,试图摆脱它的想法可能令人望而却步。然而,万维网创始人蒂姆·伯纳斯-李(Tim Berners-Lee)去年写道:“目前有两个神话限制了我们的集体想象力:一个是广告是在线公司唯一可能的商业模式的神话,另一个是改变平台运营方式为时已晚的神话。在这两点上,我们需要更有创造力。”

让产品和工程团队与信任与安全团队坐在一起

Medium的法务主管Alex Feerst撰写了一篇文章,采访了在多家大型科技公司从事信任与安全工作(包括内容审核)的15个人,Feerst将这些角色比作互联网的“法官和清洁工”。正如一位信任与安全(T&S)员工观察到的那样:“创作者和产品人员希望活在乐观中,活在人们将如何理想地使用产品的愿景中,而不是活在人们可预测地破坏产品的方式中……产品人员与信任人员的分离令我担忧,因为在一个产品经理、工程师和富有远见的人们关心这些事情的世界里,这些本应融入到事物的构建方式中。如果情况保持这样——产品和工程人员是莫扎特,其他所有人都是阿尔弗雷德管家——那么大的事情就不会改变。”

让产品和工程团队旁听甚至与信任与安全(T&S)代理人(包括内容审核员)坐在一起是解决这个问题的一种方式。这能让这些平台的创建者更清楚地了解科技平台被滥用的方式。另一家公司的T&S员工描述了这种方法:“我们让高管和产品经理在与用户通话时旁听信任与安全代理人的工作。与一位代理人坐在一起,听他们与性侵受害者通话,有助于建立一些同理心,这样当他们回到团队时,当他们在思考构建事物时,这会一直在他们脑海中运行。”

未完待续…

本文是系列的第一部分。请务必查看第二部分和第三部分,其中包含了你可以采取的进一步措施来改善科技行业。我们面临的问题可能令人难以承受,因此从这个列表中选择一个事项作为良好的开端可能会有所帮助。我鼓励你选择一件你将要做的事情,并现在就做出承诺。