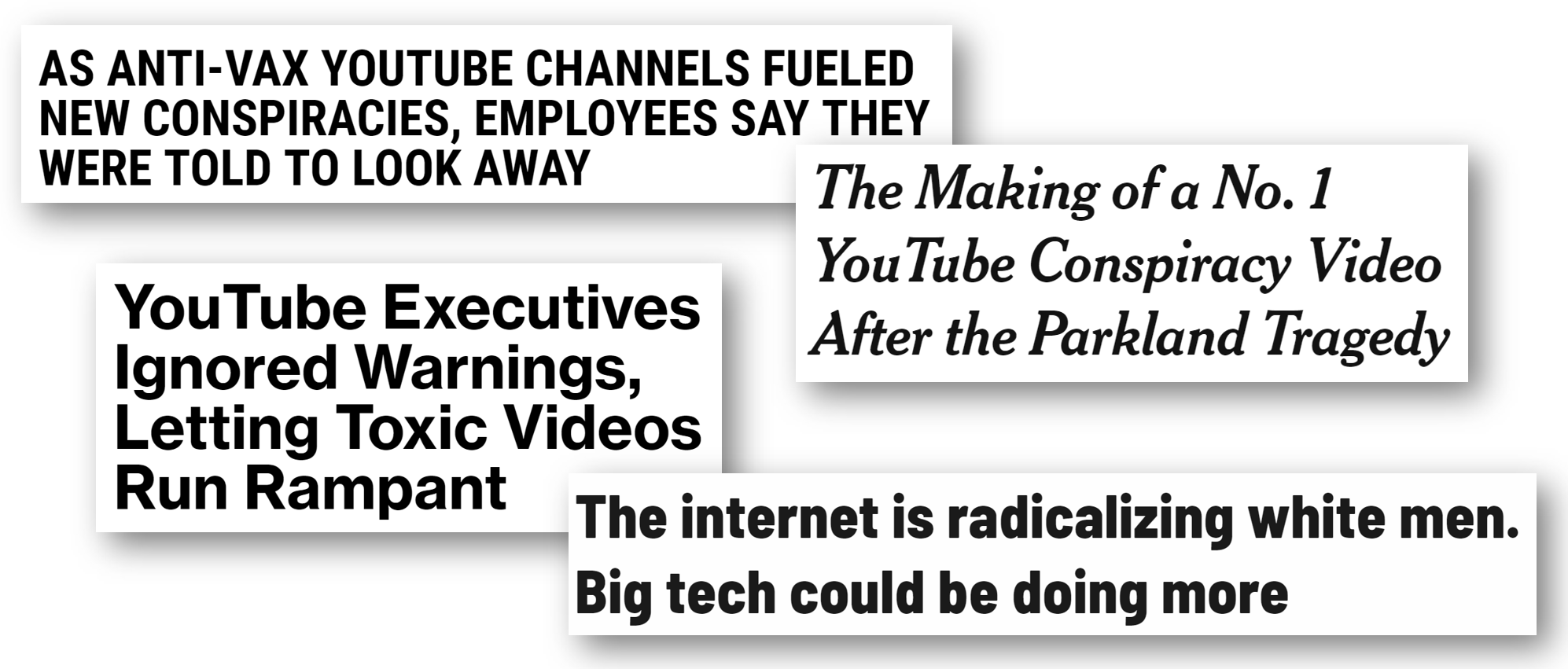

YouTube通过积极推荐(并自动播放)关于白人至上主义、反疫苗、否认大规模枪击事件、气候变化否认论以及不信任主流媒体的阴谋论视频,在人们激进化过程中起到了重要作用,推荐给那些甚至没有寻找这些内容的人。YouTube推荐内容占用户平台使用时长的70%,并且这些推荐内容不成比例地包含有害的阴谋论。YouTube的推荐算法试图最大化观看时长,而让你相信其他媒体都在说谎的内容会让你花费更多时间观看YouTube。

考虑到这一切,你可能会期望谷歌/YouTube认真对待这些问题并努力解决。然而,当《纽约时报》采访了YouTube最资深的产品主管尼尔·莫汉(Neal Mohan)时,他发表了一系列在我看来极具误导性、延续了误解、否认了责任并淡化了一个已经毁掉无数生命的问题的言论。莫汉已在谷歌担任高级主管超过10年,在互联网广告业拥有20年经验(这是谷歌/YouTube的核心商业模式)。谷歌以精心控制其公众形象而闻名,然而谷歌并未对莫汉的言论发布任何形式的撤回或纠正。考虑到莫汉的专业背景和谷歌对其形象的控制,我们不能轻易忽视这次采访。

通过YouTube激进化

全球范围内,人们每天观看10亿小时的YouTube(是的,没错,是每天)。YouTube成功很大程度上归功于其推荐系统,该系统会向用户显示一排推荐视频,并且一旦前一个视频结束,首个视频就会自动开始播放。这驱动了用户在YouTube上花费时长的70%。不幸的是,这些推荐内容不成比例地偏向推广白人至上主义、反疫苗、否认大规模枪击事件、气候变化否认论以及否认主流媒体来源准确性的阴谋论。“YouTube可能是21世纪最强大的激进化工具之一,”Zeynep Tufekci教授在《纽约时报》上写道。YouTube由谷歌拥有,谷歌正在通过积极地向弱势人群灌输阴谋论赚取数十亿美元,而社会其他成员则承担着外部化成本。

告诉我YouTube自动播放最终会导向各种起始点的白人至上主义视频的人数相当惊人。这需要大规模和系统的研究。https://#/NnTdQA9itK

— zeynep tufekci (@zeynep) 2018年3月12日

发生了什么?YouTube的算法是为了最大化人们观看YouTube的时长而构建的,并且阴谋论者观看YouTube的时间明显多于信任多种媒体来源的人。不幸的是,一个仅仅试图最大化其自身平台使用时长的推荐系统会激励那种告诉你其他媒体都在说谎的内容,正如YouTube内部举报人吉劳姆·查斯洛特(Guillaume Chaslot)所解释的。

在这方面开展了哪些研究?

吉劳姆·查斯洛特拥有人工智能博士学位,此前曾在谷歌的YouTube推荐系统团队工作。他编写了一款软件,使用一个“种子”短语(例如“唐纳德·特朗普”、“米歇尔·奥巴马”或“地球是圆的还是平的?”)进行YouTube搜索,并记录“待播”列表中的首个推荐视频,然后追踪其后的“待播”视频,依此类推。该软件在没有观看历史记录的情况下进行(因此推荐不受用户偏好影响),并重复进行数千次。

查斯洛特在2016年8月至11月期间收集了8000个来自“待播”推荐列表的视频:一半是搜索“克林顿”后的推荐链中的视频,另一半是搜索“特朗普”后的。当《卫报》记者分析这些视频时,他们发现这些视频反希拉里·克林顿的可能性是6倍(无论用户搜索的是“特朗普”还是“克林顿”),并且许多视频包含了疯狂的阴谋论

“有几十个片段称克林顿精神崩溃,报道她患有梅毒或帕金森病,指控她有秘密性关系,包括与小野洋子的关系。许多内容更加阴暗,捏造维基解密披露的内容,提出毫无根据的主张,指控克林顿卷入谋杀,或将她与撒旦崇拜和恋童邪教联系起来。”

这只是查斯洛特研究过的众多主题之一。查斯洛特关于YouTube推荐内容的定量研究已被《华尔街日报》、NBC、《麻省理工科技评论》、《华盛顿邮报》、《连线》和其他媒体报道。

2018年2月,谷歌承诺发表一篇博客文章驳斥查斯洛特(但至今仍未兑现)

据《哥伦比亚新闻评论》报道,“当《卫报》报道查斯洛特的研究时,他说谷歌和YouTube的代表批评了他的方法,并试图说服新闻机构不要发表这篇报道,并承诺发表一篇博客文章驳斥他的说法。但从未发表过此类文章。谷歌表示‘强烈不同意’这项研究——但在参议员马克·沃纳对YouTube推广他所谓的‘离谱、煽情且经常带有欺骗性’的内容表示担忧后,谷歌感谢《卫报》发表了这篇报道。”(原文强调)

谷歌为什么会声称有证据反驳查斯洛特的研究,却从未发表?《卫报》的这篇报道已经发表一年多了,但谷歌仍未兑现其承诺的博客文章。这让我认为谷歌在说谎。在衡量谷歌领导层近期关于YouTube的声明的真实性时,记住这一点很重要。

尼尔·莫汉错在哪里?

YouTube首席产品官尼尔·莫汉在《纽约时报》接受采访时,似乎否认了一个有充分证据的现象,忽略了该网站70%的使用时长来自自动播放推荐(反而将责任归咎于用户选择点击哪些视频),提出了一个荒谬的“双方都有”论点(即使YouTube有极端视频,他们也有非极端视频……?),并延续了误解(暗示既然极端主义不是算法的一个显式输入,那么结果就不可能偏向极端主义)。总的来说,他的回答常常显得回避,未能回答被提出的问题,而且在任何时候他似乎都没有为YouTube造成的任何错误或伤害承担责任。

甚至采访莫汉的记者似乎也感到惊讶,一度打断他以澄清,“抱歉,我能打断您一下吗?请让我确认一下:您是说YouTube没有兔子洞效应吗?”(“兔子洞效应”是指推荐系统逐渐推荐越来越极端的视频。)作为回应,莫汉将责任归咎于用户,并且仍然未能给出直接了当的答案。

背景资料:莫汉于1997年开始在DoubleClick从事互联网广告业,该公司于2008年被谷歌以31亿美元收购。莫汉随后担任谷歌展示和视频广告高级副总裁7年,之后转任谷歌YouTube的首席产品官。YouTube的主要收入来源是广告,2018年,YouTube的年销售额估计为150亿美元,价值高达1000亿美元。莫汉深受谷歌喜爱,2013年,为挽留他拒绝Twitter的工作邀请,谷歌额外提供了1亿美元的股票。总而言之,这意味着莫汉拥有11年谷歌高级主管经验,以及超过20年的互联网广告业经验。

所有数据、证据和研究都表明,极端主义驱动互动,并且YouTube推广极端主义。

“‘极端’内容驱动的互动或观看时长并不比其他类型内容更高。” –尼尔·莫汉

不幸的是,任何仅仅试图最大化其自身平台使用时长的推荐系统都会激励那种告诉你其他媒体都在说谎的内容。2012年的一篇谷歌博客文章和2016年由YouTube工程师发表的一篇论文都证实了这一点:YouTube算法的设计目的是最大化观看时长。前YouTube工程师吉劳姆·查斯洛特在这里更详细地解释了这种动态。

YouTube在激进化中所扮演角色的问题已得到《华尔街日报》和《卫报》的调查、AlgoTransparency等定量研究项目以及20位现任和前任YouTube员工的证实。过去两年内离职的五名谷歌/YouTube高级人员私下引用了YouTube领导层未能解决虚假、煽动性和有害内容的问题作为他们离开的原因。莫汉竟然试图否认这一点,这看起来和YouTube上推广的许多阴谋论一样离奇。

如果@YouTube或@nealmohan有支持这一说法(即极端内容不会带来更高互动)的数据,他们绝对应该发布,因为这与关于此主题的所有现有研究和数据相矛盾。pic.twitter.com/8Sr6eDHgZG

— Rachel Thomas (@math_rachel) 2019年3月30日

根据彭博社的一项调查,谷歌领导层多次拒绝了YouTube员工试图解决甚至只是调查虚假、煽动性和有害内容问题的努力。“一名员工希望标记那些虽然未完全违反仇恨言论规定但令人不安的视频,并停止向观众推荐。另一名员工希望在一个表格中追踪这些视频,以便绘制其受欢迎程度。第三名员工担忧‘另类右翼’视频博主的传播,创建了一个内部垂类,显示了他们的受欢迎程度。每次他们得到的都是同样的基本回应:不要惹麻烦……2018年2月,一个称帕克兰枪击案受害者为‘危机演员’的视频在YouTube的热门页面上疯传。政策人员随后建议将该页面的推荐限制在经过审查的新闻来源。YouTube管理层拒绝了这一提议。”

70%的YouTube观看量来自自动播放其推荐内容

“我不是说用户不可能点击那些被称之为更极端的视频,观看它们,然后获得另一组推荐,然后某种程度上继续朝着某个方向前进。我只是说,这不是不可避免的。” –尼尔·莫汉

这一说法忽略了YouTube自动播放与推荐功能协同工作的方式,根据尼尔·莫汉之前的一次演讲,这驱动了用户在该网站上花费时长的70%。是的,从技术上讲,这不是“不可避免的”,但它驱动了每天7亿小时的观看视频(10亿小时的70%)。莫汉的说法暗示用户是选择点击极端视频的,而在大多数情况下,视频是由YouTube选择并自动开始播放的,无需任何点击。

案例研究:亚历克斯·琼斯

要理解YouTube自动播放推荐的作用,理解托管内容和推广内容之间的区别至关重要。举例来说,YouTube曾推荐InfoWars主管亚历克斯·琼斯(Alex Jones)150亿次(在2018年8月封禁他之前)。如果你不熟悉亚历克斯·琼斯,南方贫困法律中心将他评为当代最多产的阴谋论者。他的阴谋论之一是,2012年造成20名儿童遇难的桑迪胡克小学枪击案是假的,遇难儿童的父母都在说谎。这导致了针对这些悲痛欲绝的父母长达数年的骚扰活动——许多父母不得不多次搬家以逃避骚扰,最近一名父亲自杀身亡。亚历克斯·琼斯还宣扬白人至上主义、反对疫苗,并声称帕克兰校园枪击案的受害者是“危机演员”。

我在谷歌工作时参与开发的算法,向全国一些最脆弱的人推荐了亚历克斯·琼斯的视频超过150亿次。

— 吉劳姆·查斯洛特 (@gchaslot) 2018年2月25日

问题不在于人们搜索亚历克斯·琼斯的视频;问题在于YouTube向那些根本没有寻找这些视频的人推荐(并经常开始自动播放)了亚历克斯·琼斯的视频达150亿次。最近,YouTube一直在积极推广今日俄罗斯(RT)的内容,这是一个俄罗斯国有宣传机构。

正如计算宣传专家Renee DiResta为《连线》撰文所写,“没有基于第一修正案的推广权——算法已经在决定你看到什么了。基于内容的推荐系统和协同过滤永远不是中立的;它们在决定向你展示什么时,总是在将一个视频、帖子或群体与其他视频、帖子或群体进行排名。”自动播放阴谋论增加了YouTube的收入——随着人们被激进化,他们停止花时间在主流媒体上,而将越来越多的时间花在YouTube上。

算法可能因非数据集中的变量而产生偏见。

“我想说的是,当观看一个视频时,你会看到许多其他视频被推荐。其中一些视频可能被认为偏向一个方向,或者说,更极端。也有一些视频偏向相反的方向,” 莫汉给出了一个含糊的“双方都有”辩护,尽管不清楚不那么极端的视频如何平衡更极端的视频。他接着说,“再次声明,我们的系统没有这样做,因为这不是一个输入推荐系统的信号。” 莫汉暗示,由于极端主义不是输入算法的一个显式变量,所以算法不会偏向极端主义内容。 这是错误的,但却是一个常见且危险的误解。

算法可以(而且通常会)因非数据集中的变量而产生偏见。事实上,这就是机器学习的作用:它提取潜在变量。例如,用于美国许多法庭作为保释、判决或假释决定一部分的COMPAS累犯风险评估算法,被发现对黑人被告的假阳性率几乎是白人被告的两倍。也就是说,被标记为“高风险”的黑人被告中有45%没有再犯罪;而白人被告中这一比例为24%。种族不是这个软件的输入变量,因此按照莫汉的推理,应该没有问题。

提醒:算法可以因非数据集中的变量而产生偏见。

— Rachel Thomas (@math_rachel) 2019年3月30日

例:种族不是COMPAS累犯风险评估算法的输入变量,但结果却存在种族偏见。

YouTube不将极端主义作为变量,但其结果偏向极端主义。

忽略种族、性别或极端主义等因素不仅不能保护你免受偏见结果的影响,许多机器学习专家反而建议相反的做法:你需要衡量这些指标,以确保你没有受到不公正的偏见影响。

和世界上许多人一样,我对白人至上主义运动的复苏和持续否认气候变化的现象感到震惊,想到YouTube通过积极向那些根本没有寻找这些内容的人推广此类阴谋论赚了多少钱,我就感到厌恶。我大部分时间都在研究人工智能伦理,过去两年里,我在主题演讲中一直将YouTube的行为作为一个例子(反面教材)。尽管我知道大型科技公司除非受到有意义的监管强制,否则不会做正确的事情,但这次《纽约时报》的采访仍然令我沮丧。谷歌/YouTube不仅仍然不认真对待这些问题,而且他们认为我们其他人会受到他们误导性的企业套话和不成熟的推诿的安抚,这简直是一种侮辱。